CompartilharComentarSiga-nos no![]() A A

A A

Em processo inédito, uma mãe americana abriu uma ação judicial nos EUA contra a startup de inteligência artificial Character.AI e o Google, alegando que a interação do filho com um chatbot teria contribuído para sua morte.

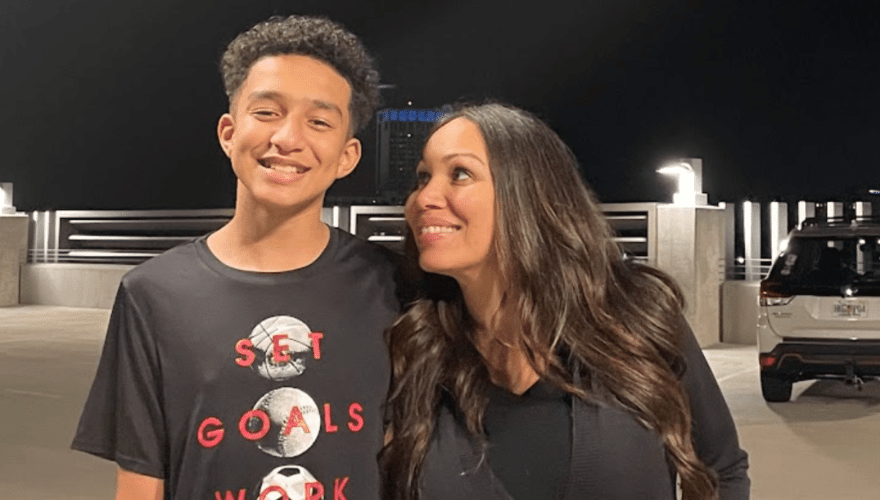

Segundo Megan Garcia, advogada e mãe do jovem, Sewell Setzer ficou emocionalmente dependente de “Daenerys”, personagem criado pela IA da empresa, que oferecia “experiências antropomórficas, hipersexualizadas e assustadoramente realistas”.

Em mensagens finais com o bot, ele teria afirmado: “Eu prometo que voltarei para você”. Pouco depois, o adolescente foi encontrado morto em sua casa.

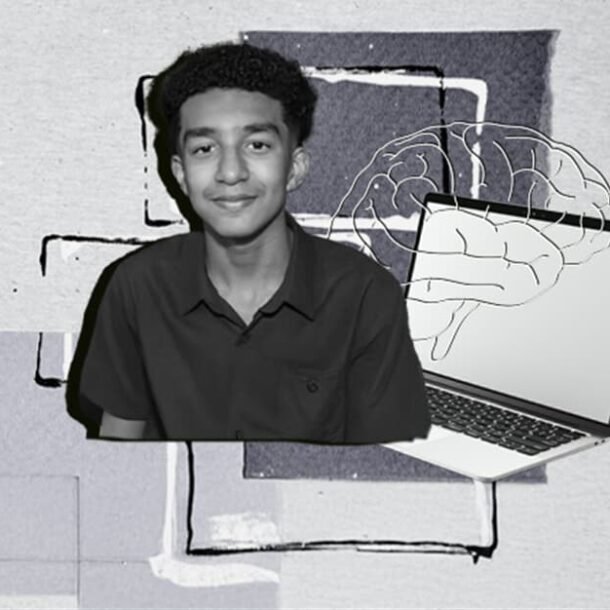

Mãe processa Character.AI por suicídio do filho após interação com chatbot.(Imagem: Reprodução/Megan Garcia)

O advogado especialista em Crimes Cibernéticos Luiz Augusto D’Urso, do escritório D’Urso e Borges Advogados Associados, alertou que, se um caso similar ocorresse no Brasil, as famílias enfrentariam obstáculos legais para responsabilizar as empresas.

“Hoje, no Brasil, nós não temos nenhuma lei em vigor que regulamente a inteligência artificial, nós temos projetos de lei”, explicou D’Urso, ressaltando a lacuna de leis para lidar com o tema.

A falta de um arcabouço legal específico, segundo D’Urso, dificulta qualquer tentativa de responsabilização. “Nós teríamos uma dificuldade gigantesca em debater esse caso […] e tentar responsabilizar as empresas”, apontou.

Para ele, sem uma regulamentação clara, seria “muito difícil” que a Justiça reconhecesse a responsabilidade de uma empresa em um caso dessa natureza.

D’Urso defende urgência na criação de leis que possam garantir uma interação segura para os usuários brasileiros, principalmente no que tange à proteção de crianças e adolescentes.

“A regulamentação é urgente e necessária, porque poderá trazer uma previsão legal e segurança jurídica da responsabilidade de todas essas empresas que produzem IA […] podem causar danos emocionais, induzir a morte jovens, crianças, adolescentes e até adultos.”

Outro ponto crucial mencionado pelo advogado é a ausência de previsão penal para responsabilizar empresas quando danos emocionais levarem a consequências graves, como a morte.

“Do ponto de vista da responsabilidade penal, seria muito difícil qualquer tipo de aplicação da previsão legal num caso como esse, em que uma máquina […] acaba prejudicando emocionalmente um jovem a ponto dele tirar a própria vida”, avaliou D’Urso.

Ele sugere que, com a regulamentação, seja incluída a possibilidade de responsabilidade penal da pessoa jurídica nesses casos.

Além disso, o advogado destacou que a LGPD trata do tratamento de dados, mas não regulamenta o desenvolvimento e a atuação da inteligência artificial. Embora a ANPD – Autoridade Nacional de Proteção de Dados fiscalize questões de privacidade, a aplicação sobre o funcionamento ético e a segurança de interações com IAs ainda é um campo nebuloso.

D’Urso ressaltou a falta de casos semelhantes como referência no Brasil:

“Da responsabilidade civil, isso seria uma […] questão inédita no Judiciário. Nós não temos precedente para dizer o que poderia acontecer. Mas nós também não temos lei hoje em vigor para dar segurança jurídica.”

“A internet conecta o mundo, mas nem toda plataforma produzida no exterior pode ser livremente utilizada por jovens no Brasil. […] Há plataformas que não são adequadas para menores ou que nem deveriam existir”, afirmou D’Urso, frisando a importância de um controle rígido sobre as interações com essas tecnologias.

O caso nos Estados Unidos, segundo o advogado, é um alerta para que o Brasil adote medidas preventivas e regulatórias antes que ocorrências semelhantes impactem diretamente a sociedade brasileira.

Veja a entrevista completa com o advogado:

Entre a inovação e a segurança

O impacto das novas tecnologias sobre a saúde mental dos jovens coloca em debate a responsabilidade das empresas de IA e redes sociais. Algoritmos e personagens interativos, projetados para maximizar o engajamento, podem gerar laços emocionais intensos, resultando até em dependência.

O desafio jurídico está em definir até onde vai à responsabilidade dessas plataformas pelos efeitos psicológicos e sociais, especialmente ao lidar com o público infantojuvenil. Afinal, como equilibrar inovação e segurança na era digital?